CHIA SẺ KIẾN THỨC

Gemma 3 270M: Sức Mạnh Của AI Chuyên Dụng Siêu Hiệu Quả

Khám phá Gemma 3 270M, mô hình AI nền tảng của Google, được thiết kế để tinh chỉnh (fine-tune). Hướng dẫn tạo ra các AI chuyên dụng, siêu hiệu quả và tiết kiệm chi phí.

Trong nhiều năm, cuộc đua AI dường như chỉ có một hướng. Đó là tạo ra các mô hình ngày càng lớn hơn. Nhưng một cuộc cách mạng thầm lặng đang diễn ra. Tương lai không chỉ thuộc về sức mạnh thô. Nó thuộc về sự thông minh, hiệu quả và chuyên môn hóa. Google đã khẳng định xu hướng này với Gemma 3 270M.

Đây không phải là một “chatbot bỏ túi” đa năng. Thay vào đó, nó là một công cụ chuyên dụng. Nó là một nền tảng vững chắc được thiết kế từ đầu cho việc tinh chỉnh (fine-tuning). Hãy tưởng tượng bạn sẽ không dùng búa tạ để treo một bức tranh. Gemma 3 270M chính là công cụ chính xác cho những công việc cụ thể. Nó cho phép các nhà phát triển tạo ra một “đội quân” các mô hình chuyên gia. Mỗi mô hình đều cực kỳ hiệu quả trong một nhiệm vụ riêng. Bài viết này sẽ là hướng dẫn toàn diện nhất, giúp bạn hiểu và khai thác triết lý mạnh mẽ này.

Gemma 3 270M là gì? Nền tảng cho các chuyên gia AI

Hãy xem Gemma 3 270M như một khối đất sét chất lượng cao. Nó có tiềm năng vô hạn. Nhưng vẻ đẹp thực sự của nó chỉ lộ ra khi được một nghệ nhân (nhà phát triển) nhào nặn thành một tác phẩm cụ thể. Nó là một mô hình ngôn ngữ cơ sở (base model) được xây dựng để trở thành điểm khởi đầu hoàn hảo.

Giải mã cấu trúc 270 triệu tham số

Kích thước nhỏ gọn của mô hình không phải là ngẫu nhiên. Nó được thiết kế rất thông minh.

-

170 triệu tham số dành cho việc nhúng (embedding). Phần này giống như một cuốn từ điển khổng lồ, giúp mô hình hiểu ý nghĩa của từng từ.

-

100 triệu tham số dành cho các khối biến áp (transformer blocks). Phần này giống như bộ não xử lý, giúp mô hình suy luận và tạo ra các câu trả lời logic.

Cấu trúc này tối ưu cho hiệu suất và khả năng học hỏi khi được tinh chỉnh.

Sức mạnh ẩn giấu của bộ từ vựng 256k

Một trong những điểm nổi bật nhất của Gemma 3 270M là bộ từ vựng (vocabulary) khổng lồ với 256,000 token. Hầu hết các mô hình khác chỉ có 32,000 hoặc 128,000. Kích thước lớn này mang lại lợi thế vượt trội:

-

Hiểu thuật ngữ chuyên ngành: Nó có thể xử lý các thuật ngữ y khoa, pháp lý, kỹ thuật một cách hiệu quả hơn.

-

Nền tảng đa ngôn ngữ: Nó là một cơ sở tuyệt vời để tinh chỉnh cho các ngôn ngữ khác, đặc biệt là các ngôn ngữ có bộ chữ phức tạp.

Hiệu quả năng lượng: AI dành cho thế giới di động

Mô hình này được tối ưu để tiêu thụ năng lượng cực thấp. Các thử nghiệm trên điện thoại Pixel cho thấy nó rất tiết kiệm pin. Điều này mở ra cánh cửa cho các ứng dụng AI mạnh mẽ chạy trực tiếp trên điện thoại. Các ứng dụng này sẽ không làm cạn kiệt pin của người dùng.

Triết lý “Công cụ phù hợp”: Sức mạnh của sự chuyên môn hóa

Sức mạnh thực sự của Gemma 3 270M không nằm ở việc nó có thể làm mọi thứ. Sức mạnh của nó nằm ở việc nó có thể được dạy để làm một việc cực kỳ tốt.

Cách tiếp cận này hiệu quả hơn rất nhiều. Thay vì dùng một mô hình API khổng lồ, tốn kém cho mọi tác vụ, bạn có thể tinh chỉnh Gemma 3. Bạn sẽ tạo ra một mô hình chuyên gia cho việc phân loại email. Một mô hình khác để trích xuất thông tin hóa đơn. Và một mô hình nữa để kiểm duyệt bình luận. Mỗi mô hình chuyên gia này sẽ nhanh hơn, rẻ hơn và thường chính xác hơn mô hình lớn trong nhiệm vụ của nó.

Bài học từ thực tế: Case study của SK Telecom

Adaptive ML đối mặt với một thách thức lớn. Họ cần kiểm duyệt nội dung đa ngôn ngữ phức tạp cho SK Telecom. Thay vì dùng một API đắt đỏ, họ đã tinh chỉnh một mô hình Gemma. Kết quả thật ấn tượng. Mô hình Gemma chuyên biệt không chỉ đáp ứng mà còn vượt qua hiệu suất của các mô hình độc quyền lớn hơn rất nhiều. Đây là minh chứng rõ ràng cho sức mạnh của sự chuyên môn hóa.

Một giới hạn quan trọng cần biết: Đây không phải là đối thủ của ChatGPT

Google đã nêu rất rõ: mô hình này không được thiết kế cho các cuộc hội thoại phức tạp, đa chiều. Nó không phải là đối thủ cạnh tranh của ChatGPT trong các cuộc trò chuyện dài. Mục đích của nó là thực thi các mệnh lệnh và nhiệm vụ được xác định rõ ràng một cách hiệu quả. Đặt kỳ vọng đúng đắn là chìa khóa để khai thác thành công mô hình này.

Khi nào bạn nên chọn Gemma 3 270M?

Đây là lựa chọn hoàn hảo nếu bạn đang ở trong các tình huống sau:

-

Nhiệm vụ rõ ràng, khối lượng lớn: Các công việc lặp đi lặp lại như phân tích cảm xúc từ hàng nghìn bình luận, định tuyến các ticket hỗ trợ khách hàng đến đúng bộ phận, hay trích xuất thông tin từ tài liệu phi cấu trúc.

-

Cần tối ưu từng mili giây và chi phí: Khi bạn xây dựng một ứng dụng, độ trễ vài giây có thể khiến người dùng thất vọng. Mô hình chạy cục bộ giúp giảm độ trễ xuống gần như bằng không. Nó cũng giúp bạn loại bỏ hoàn toàn chi phí API đắt đỏ.

-

Cần lặp lại và triển khai nhanh: Trong phát triển phần mềm, tốc độ là tất cả. Quá trình tinh chỉnh Gemma 3 270M chỉ mất vài giờ. Điều này cho phép đội ngũ của bạn thử nghiệm nhiều ý tưởng và tìm ra giải pháp tối ưu một cách nhanh chóng.

-

Yêu cầu bảo mật và quyền riêng tư cao: Các ứng dụng y tế, tài chính hoặc pháp lý không thể gửi dữ liệu nhạy cảm của người dùng lên đám mây. Chạy AI cục bộ là giải pháp duy nhất để đảm bảo an toàn tuyệt đối.

Hướng dẫn chi tiết: Bắt đầu hành trình với Gemma 3 270M

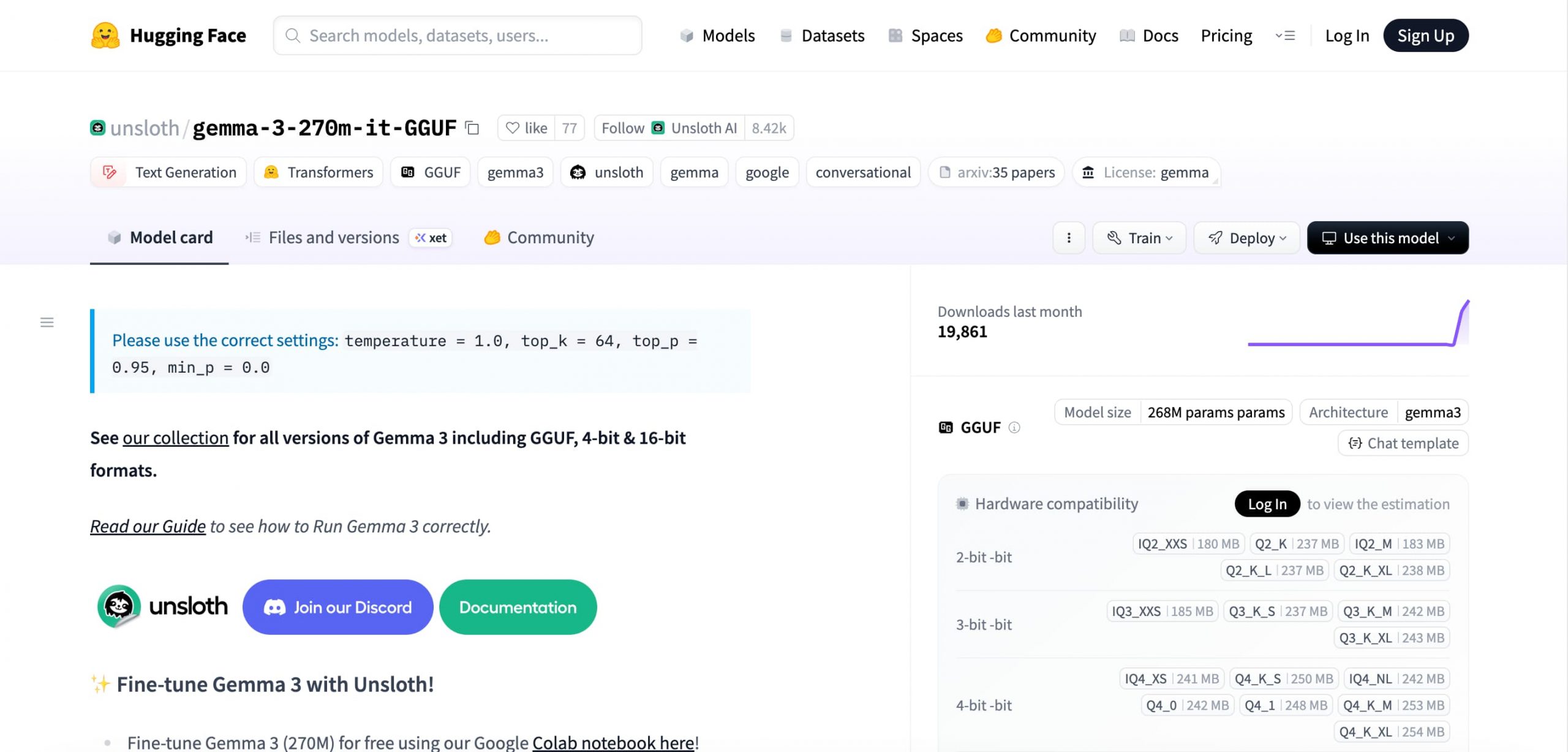

Dưới đây là hai cách để bạn tiếp cận mô hình này. Để xem tài liệu gốc từ Unsloth AI, bạn có thể tham khảo hướng dẫn chi tiết tại đây.

Cách 1: Trải nghiệm nhanh (Dùng thử khả năng cơ bản)

Cách này giúp bạn hình dung về khả năng tuân thủ mệnh lệnh của mô hình. Hãy thử đưa ra các chỉ dẫn đơn giản, một lần để xem nó phản hồi như thế nào.

-

Bước 1: Chọn công cụ: Tải về LM Studio, Ollama, hoặc Jan.

-

Bước 2: Tải mô hình GGUF:

-

Truy cập vào trang Hugging Face của Unsloth.

-

Tải file có tên gemma-3-270m-it-Q4_K_M.gguf. Đây là phiên bản cân bằng tốt nhất giữa tốc độ và chất lượng.

-

-

Bước 3: Tải và ra lệnh: Mở phần mềm, tải file GGUF và bắt đầu đưa ra các chỉ dẫn.

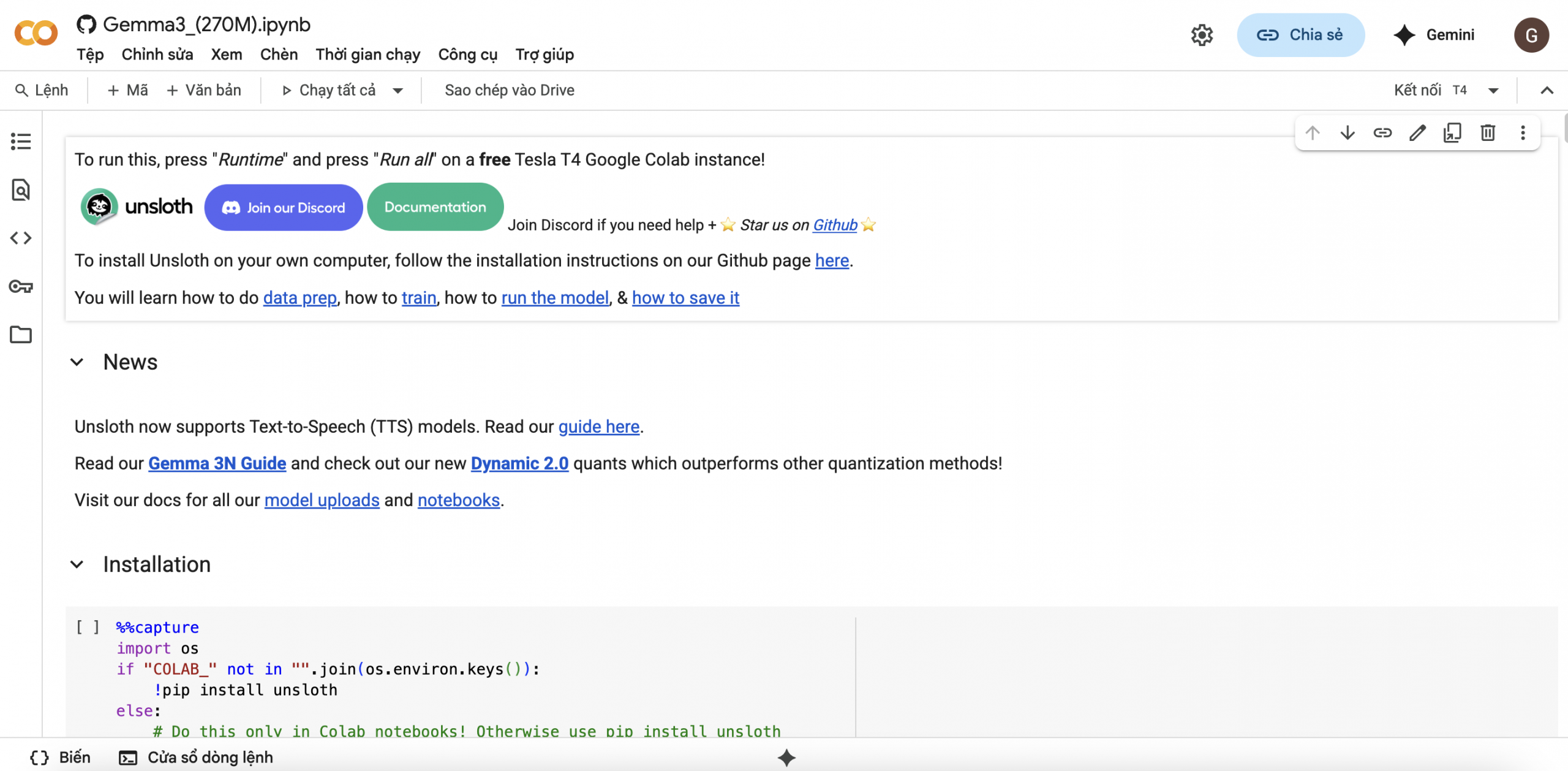

Cách 2: Tinh chỉnh (Khai phá sức mạnh thực sự)

Đây là cách sử dụng đúng với triết lý của Gemma 3 270M. Bạn sẽ cung cấp cho nó một “cuốn sách giáo khoa” về nhiệm vụ bạn muốn nó thực hiện.

-

Bước 1: Mở phòng thí nghiệm Colab: Truy cập vào notebook của Unsloth tại đây.

-

Bước 2: Chuẩn bị dữ liệu: Tạo một file chứa các cặp chỉ dẫn và kết quả mong muốn. Dữ liệu càng chất lượng, mô hình chuyên gia của bạn càng thông minh.

-

Bước 3: Bắt đầu huấn luyện: Chạy các ô mã trong notebook. Quá trình này rất nhanh chóng.

-

Bước 4: Triển khai chuyên gia AI của bạn: Sau khi hoàn tất, bạn có thể xuất mô hình đã tinh chỉnh và triển khai nó vào ứng dụng của mình.

Unsloth AI: Chất xúc tác cho quá trình tinh chỉnh

Nếu Gemma 3 270M là nguyên liệu, thì Unsloth AI chính là bộ dụng cụ nhà bếp cao cấp. Thư viện này giúp quá trình tinh chỉnh trở nên cực kỳ hiệu quả. Nó sử dụng các thuật toán thông minh để tối ưu hóa việc sử dụng bộ nhớ. Nó cũng tăng tốc độ huấn luyện lên nhiều lần. Điều này giúp dân chủ hóa quá trình tinh chỉnh. Giờ đây, các nhà phát triển cá nhân và các nhóm nhỏ cũng có thể tạo ra các mô hình chuyên gia mạnh mẽ mà không cần đến siêu máy tính.

Câu hỏi thường gặp (FAQ)

1. Vậy Gemma 3 270M không phải là một chatbot như ChatGPT?

Đúng vậy. Nó không được thiết kế để trò chuyện dài và phức tạp. Nó là một mô hình nền tảng để thực thi các mệnh lệnh. Sức mạnh của nó được bộc lộ sau khi được tinh chỉnh cho các tác vụ cụ thể.

2. Mô hình này có thể thay thế được các mô hình lớn như GPT-4 không?

Không, chúng phục vụ các mục đích khác nhau. GPT-4 là một “búa tạ” đa năng. Gemma 3 270M là nguyên liệu để bạn tạo ra những “con dao mổ” chính xác, hiệu quả và tiết kiệm chi phí cho từng công việc.

3. Tôi cần kỹ năng gì để tinh chỉnh mô hình này?

Bạn cần có kiến thức cơ bản về Python và hiểu về cách hoạt động của các notebook (như Google Colab). Notebook của Unsloth đã được thiết kế rất thân thiện. Nó sẽ hướng dẫn bạn qua từng bước.

4. Chi phí để tinh chỉnh Gemma 3 270M là bao nhiêu?

Với các công cụ như Google Colab và Unsloth AI, chi phí có thể gần như bằng không. Bạn có thể sử dụng GPU miễn phí do Colab cung cấp. Điều này làm cho việc thử nghiệm và học hỏi trở nên cực kỳ dễ tiếp cận.

Gemma 3 270M đại diện cho một hướng đi thông minh và bền vững cho tương lai của AI. Thay vì chỉ theo đuổi sức mạnh thô, nó tập trung vào hiệu quả, sự chuyên môn hóa và khả năng tiếp cận. Bằng cách trao cho các nhà phát triển một nền tảng vững chắc để xây dựng, Google đang mở ra một kỷ nguyên mới của các ứng dụng AI tinh gọn, nhanh chóng và hiệu quả về chi phí. Đây là thời điểm không thể tốt hơn để bắt đầu tạo ra các chuyên gia AI của riêng bạn.