CHIA SẺ KIẾN THỨC

Prompt Engineering Toàn Tập: Từ Cơ Bản Đến Chuyên Sâu – Làm Chủ Nghệ Thuật Giao Tiếp Với AI (Tối ưu System Prompt)

Prompt Engineering toàn tập: từ cơ bản đến chuyên sâu. Làm chủ nghệ thuật giao tiếp AI, tối ưu câu lệnh và system prompt.

Chào mừng bạn đến với thế giới của Prompt Engineering! Trong kỷ nguyên của Trí tuệ nhân tạo (AI) và đặc biệt là các Mô hình Ngôn ngữ Lớn (LLM) như GPT-3, GPT-4, Claude, Llama, việc biết cách “nói chuyện” hiệu quả với AI đã trở thành một kỹ năng vô giá. Prompt Engineering chính là nghệ thuật và khoa học của việc thiết kế những “câu lệnh” (prompt) tối ưu, bao gồm cả việc xây dựng system prompt nền tảng, để AI hiểu và thực hiện yêu cầu của bạn một cách chính xác, sáng tạo và hiệu quả nhất.

Bài hướng dẫn này sẽ đưa bạn đi từ những viên gạch nền tảng đến các kỹ thuật phức tạp, giúp bạn tự tin làm chủ kỹ năng này.

Phần 1: Nền Tảng Vững Chắc – Những Điều Cơ Bản Về Prompt

1.1. Prompt là gì?

Hiểu đơn giản, Prompt là đầu vào (input) mà bạn cung cấp cho một Mô hình Ngôn ngữ Lớn. Nó có thể là một câu hỏi, một mệnh lệnh, một đoạn văn bản, một đoạn code, hay thậm chí là một vài từ khóa. Dựa trên prompt này, LLM sẽ tạo ra một đầu ra (output) tương ứng.

Ví dụ Prompt đơn giản:

- “Thủ đô của Pháp là gì?”

- “Viết một bài thơ về mùa thu.”

- “Tóm tắt đoạn văn sau: [đoạn văn]”

1.2. Tại sao Prompt lại quan trọng?

Chất lượng của prompt ảnh hưởng trực tiếp đến chất lượng của output. Một prompt mơ hồ, thiếu thông tin sẽ dẫn đến câu trả lời không chính xác, lạc đề hoặc không như ý. Ngược lại, một prompt hiệu quả cho AI, được thiết kế tốt sẽ hướng dẫn AI tạo ra kết quả tuyệt vời.

Prompt tốt = Output tốt.

Lợi ích của Prompt Engineering

Prompt Engineering giúp bạn:

- Kiểm soát hành vi của AI.

- Nâng cao độ chính xác và liên quan của kết quả.

- Khai thác khả năng sáng tạo của AI.

- Tiết kiệm thời gian và công sức.

1.3. Các Thành tố Cơ bản của một Prompt Hiệu quả:

Dù ở mức độ nào, một prompt tốt thường chứa đựng sự rõ ràng về:

- Nhiệm vụ (Task): Bạn muốn AI làm gì? (Ví dụ: trả lời, viết, tóm tắt, dịch, phân loại, tạo code).

- Ngữ cảnh (Context): Thông tin nền tảng mà AI cần biết để thực hiện nhiệm vụ.

- Vai trò (Persona – tùy chọn nhưng hữu ích): Bạn muốn AI đóng vai ai? (Ví dụ: chuyên gia, nhà thơ, giáo viên). Yếu tố này thường được định nghĩa trong system prompt.

- Định dạng (Format – tùy chọn): Bạn muốn kết quả được trình bày như thế nào? (Ví dụ: gạch đầu dòng, đoạn văn, JSON, bảng). Việc xác định rõ định dạng prompt giúp AI trả về kết quả dễ sử dụng hơn.

- Ví dụ (Examples – tùy chọn, đặc biệt cho few-shot): Cung cấp một vài ví dụ về cách bạn muốn AI phản hồi.

1.4. Các Loại Prompt Cơ bản

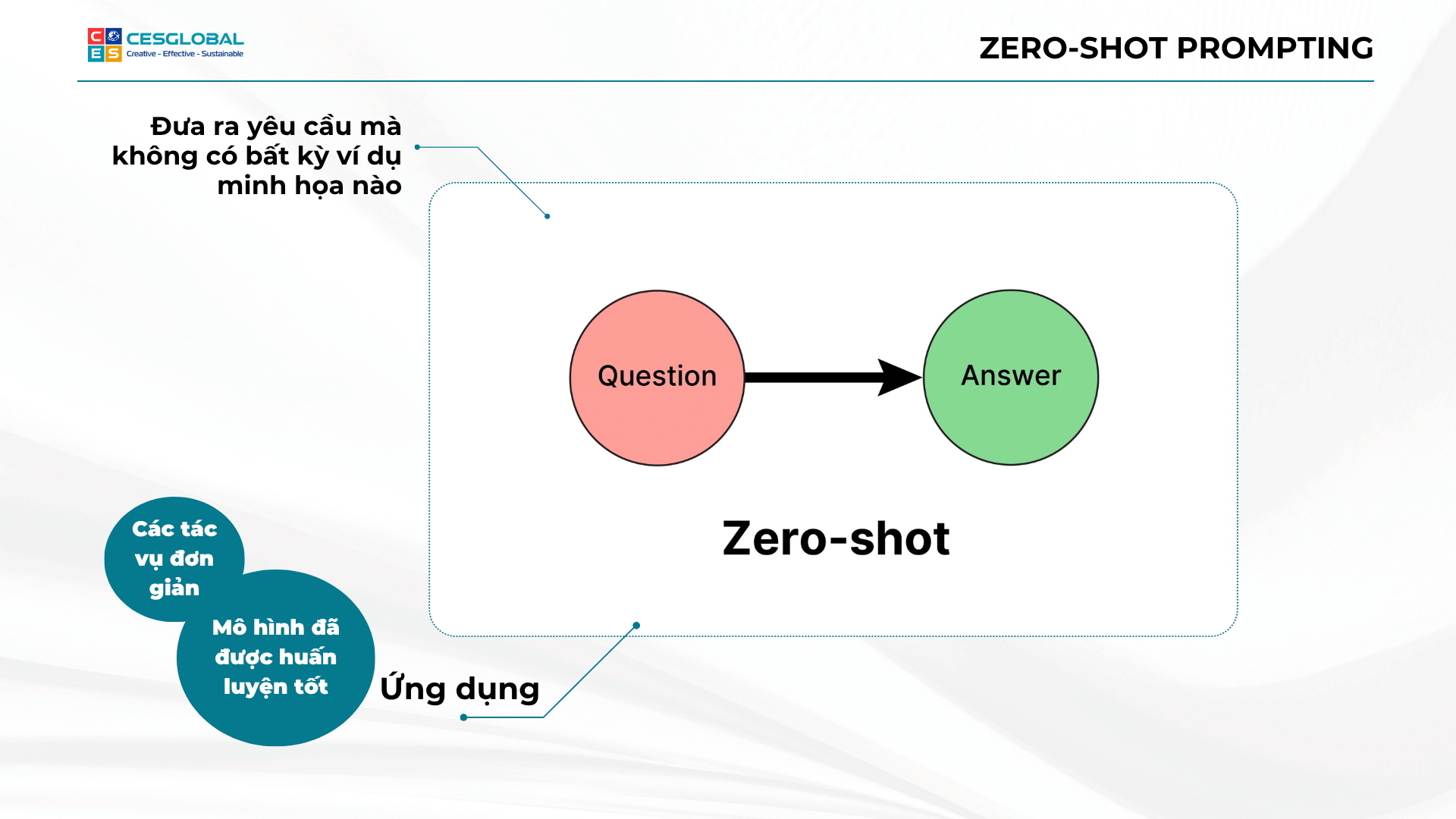

1.4.1. Zero-Shot Prompting

Bạn chỉ đưa ra yêu cầu mà không cung cấp bất kỳ ví dụ nào. LLM sẽ cố gắng hiểu và thực hiện dựa trên kiến thức đã được huấn luyện.

Ví dụ: “Dịch câu sau sang tiếng Anh: Tôi yêu Việt Nam.”

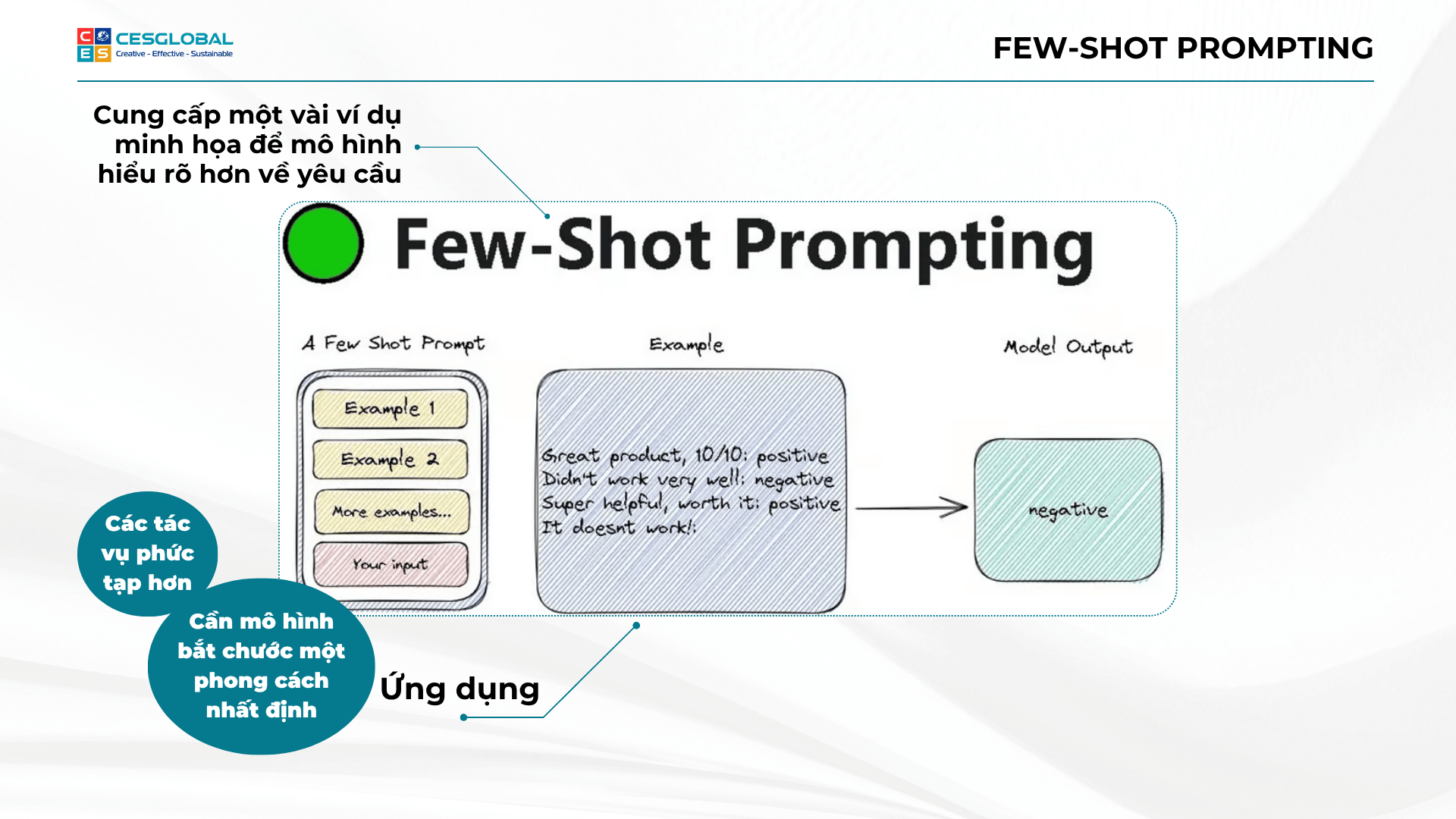

1.4.2. Few-Shot Prompting

Bạn cung cấp một vài ví dụ (shots) về cặp “input – output” mong muốn để hướng dẫn AI. Điều này giúp AI hiểu rõ hơn về định dạng và kiểu phản hồi bạn cần.

Ví dụ:

Câu: Biển hôm nay thật đẹp. Cảm xúc: Tích cực.

Câu: Trời mưa tầm tã, buồn quá. Cảm xúc: Tiêu cực.

Câu: Cuốn sách này cũng tạm được. Cảm xúc: Trung tính.

Câu: Bộ phim này thật tuyệt vời! Cảm xúc: [AI tự điền]

Phần 2: Kỹ Thuật Prompting Trung Cấp – Nâng Cao Chất Lượng Output

Khi đã nắm vững cơ bản, bạn có thể áp dụng các kỹ thuật sau để tinh chỉnh và cải thiện đáng kể kết quả từ AI.

2.1. System Prompt (System Instruction): Kim Chỉ Nam Cho AI

Như đã thảo luận chi tiết ở bài trước (nếu có), System Prompt (hay system instruction) là những chỉ dẫn nền tảng, được cung cấp cho LLM trước khi nó xử lý user prompt. Nó định hình vai trò, mục tiêu, phong cách, và các ràng buộc cho AI trong suốt phiên làm việc. Đây là một yếu tố quan trọng khi tìm hiểu cách tạo prompt cho chatbot để có một chatbot thông minh.

Cách sử dụng và Lợi ích của System Prompt

- Cách sử dụng: Đặt ở phần “System Message” hoặc phần đầu của cuộc trò chuyện nếu nền tảng hỗ trợ.

- Lợi ích: Tăng tính nhất quán, kiểm soát hành vi AI, chuyên môn hóa AI.

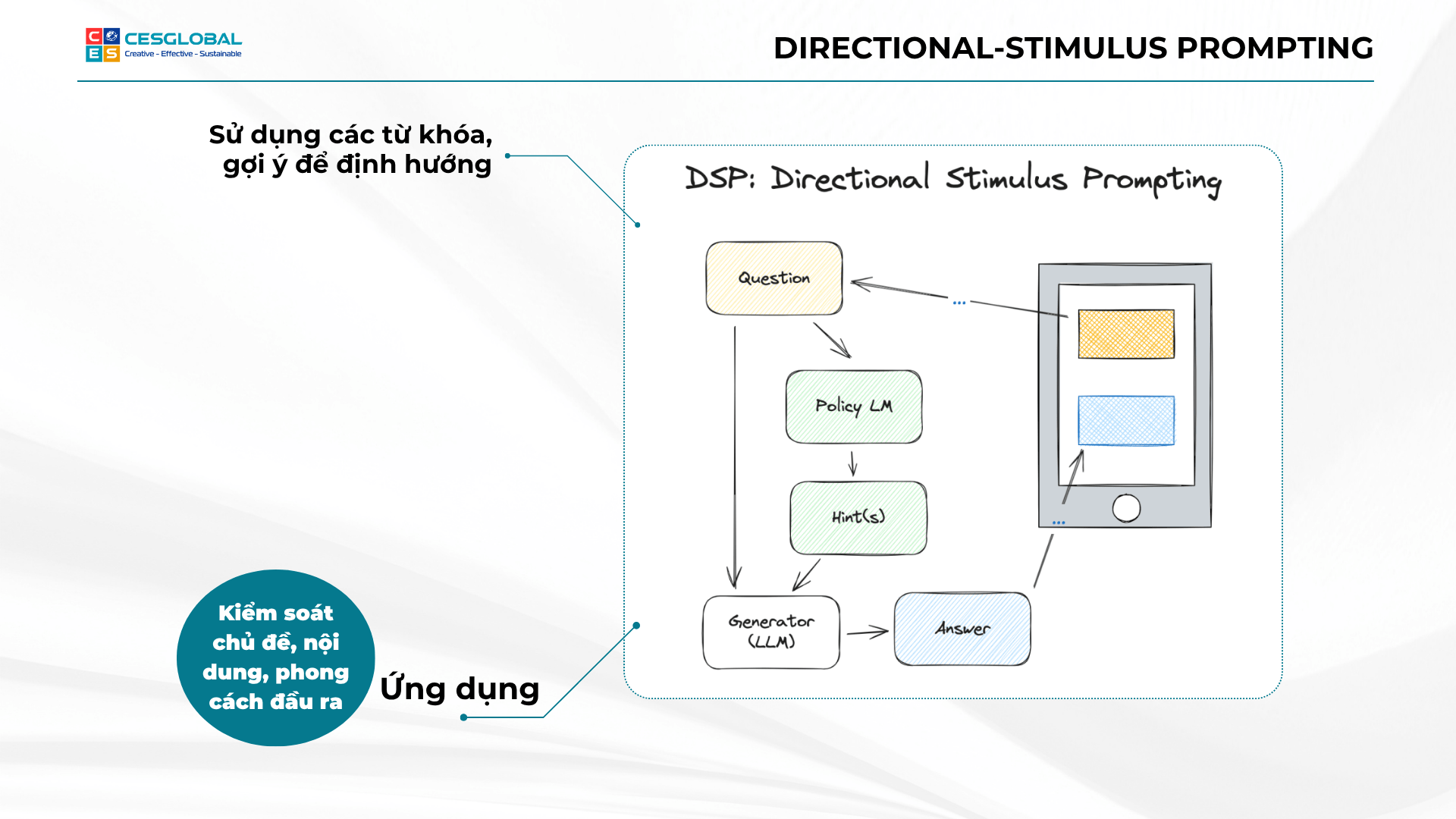

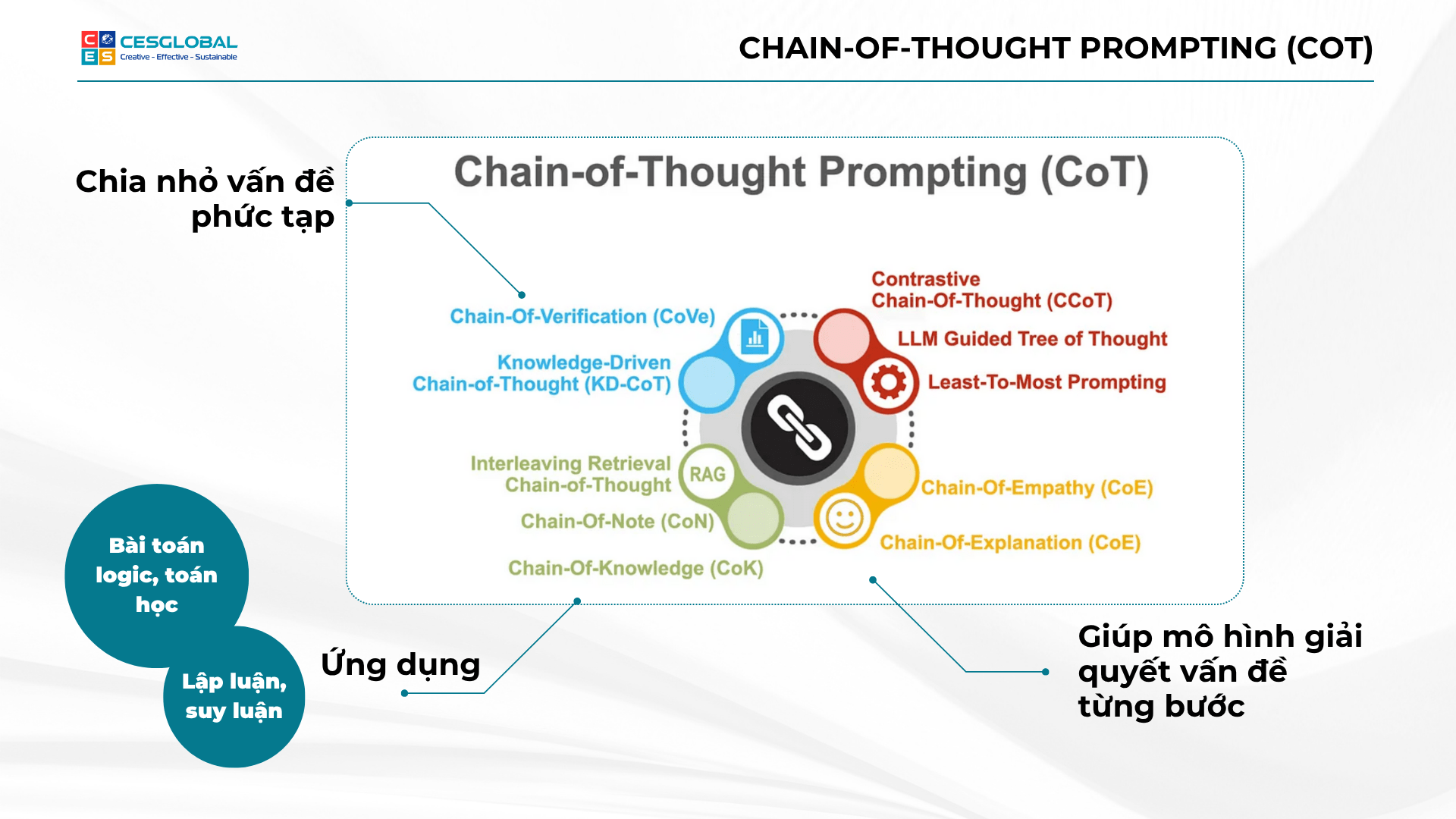

2.2. Chain-of-Thought (CoT) Prompting: Dạy AI “Suy Nghĩ” Từng Bước

Kỹ thuật này đặc biệt hữu ích cho các nhiệm vụ đòi hỏi suy luận logic, toán học, hoặc các vấn đề phức tạp. Thay vì chỉ yêu cầu kết quả cuối cùng, bạn yêu cầu AI giải thích từng bước suy nghĩ của nó.

Cách thực hiện và Ví dụ CoT

- Cách thực hiện:

- Zero-Shot CoT: Thêm cụm từ như “Hãy suy nghĩ từng bước một.”

- Few-Shot CoT: Cung cấp ví dụ có quá trình suy luận.

- Ví dụ (Zero-Shot CoT):

“Một người nông dân có 17 con cừu. Tất cả trừ 9 con bị chết. Hỏi ông còn lại bao nhiêu con cừu? Hãy suy nghĩ từng bước một.”

- Lợi ích: Cải thiện độ chính xác, giúp gỡ lỗi suy nghĩ của AI.

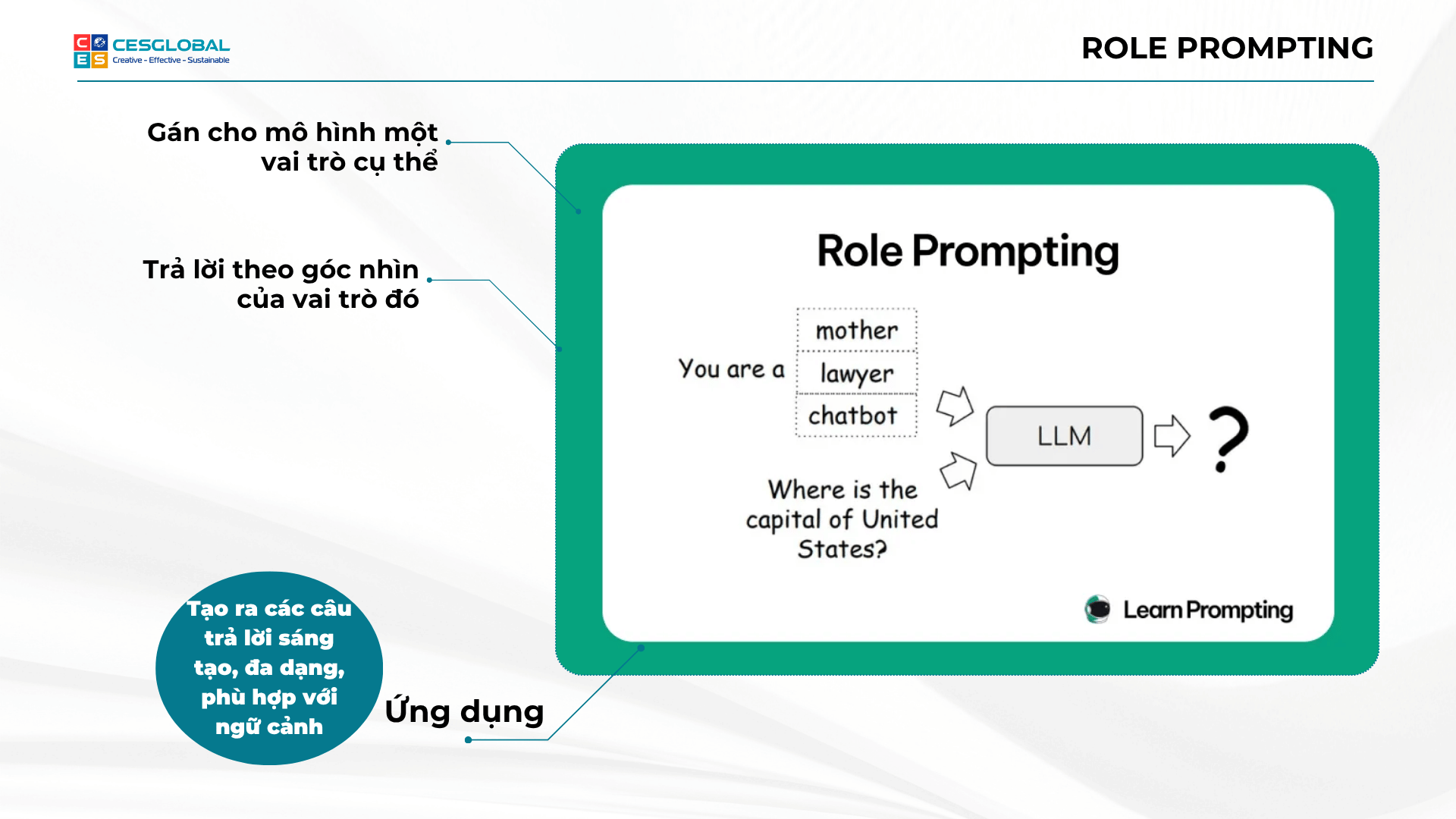

2.3. Role Prompting (Đóng Vai): Chuyên Môn Hóa AI

Yêu cầu AI đóng một vai trò cụ thể. Điều này giúp AI tập trung kiến thức và phong cách vào lĩnh vực đó. Vai trò này có thể được thiết lập hiệu quả trong system prompt.

Cách thực hiện và Ví dụ Role Prompting

- Cách thực hiện: Bắt đầu prompt bằng “Bạn là một [vai trò]…”

- Ví dụ:

- “Bạn là một chuyên gia marketing. Hãy viết một tiêu đề hấp dẫn…”

- “Bạn là một nhà sử học. Hãy giải thích nguyên nhân…”

- Lợi ích: Kết quả chuyên sâu hơn, phù hợp hơn với ngữ cảnh.

2.4. Instruction Prompting (Chỉ Dẫn Rõ Ràng): Không Để AI Đoán Mò

Cung cấp các chỉ dẫn cụ thể, rõ ràng và không mơ hồ.

Nguyên tắc và Ví dụ Instruction Prompting

- Nguyên tắc: Chủ động, Chi tiết, Tích cực.

- Ví dụ: Thay vì “Nói về mèo.” -> Nên: “Hãy liệt kê 5 đặc điểm thú vị của mèo nhà…”

- Lợi ích: Giảm mơ hồ, AI hiểu đúng ý hơn.

2.5. Output Priming & Formatting: Định Hình Kết Quả Đầu Ra

Hướng dẫn AI về cấu trúc và định dạng prompt của output bạn mong muốn.

Cách thực hiện và Ví dụ Output Priming

- Cách thực hiện:

- Yêu cầu rõ ràng: “Trả lời dưới dạng JSON”, “Sử dụng Markdown…”, “Giới hạn trong 200 từ”.

- Cung cấp một phần đầu của output mong muốn để AI tiếp nối.

- Ví dụ (Output Priming):

Dưới đây là danh sách các lợi ích của việc đọc sách:

1. Mở rộng kiến thức

[AI tiếp tục] - Lợi ích: Kết quả dễ đọc, dễ sử dụng và tích hợp.

2.6. Temperature và Top_p: Điều Chỉnh Sự “Sáng Tạo” và “Ngẫu Nhiên”

Đây là các tham số của LLM mà bạn có thể điều chỉnh (nếu nền tảng cho phép).

Giải thích về Temperature

- Temperature (0 đến 1 hoặc 2):

- Thấp (gần 0): AI sẽ đưa ra câu trả lời dễ đoán, ít ngẫu nhiên.

- Cao (gần 1 hoặc hơn): AI sẽ sáng tạo hơn, ngẫu nhiên hơn.

Giải thích về Top_p và Lưu ý

- Top_p (0 đến 1):

- Kiểm soát sự đa dạng của các từ được chọn.

- Lưu ý: Giá trị mặc định thường đã tốt.

Phần 3: Kỹ Thuật Prompting Nâng Cao – Khai Thác Sức Mạnh Tối Đa

Đây là những kỹ thuật phức tạp hơn, thường đòi hỏi sự thử nghiệm và lặp lại nhiều hơn.

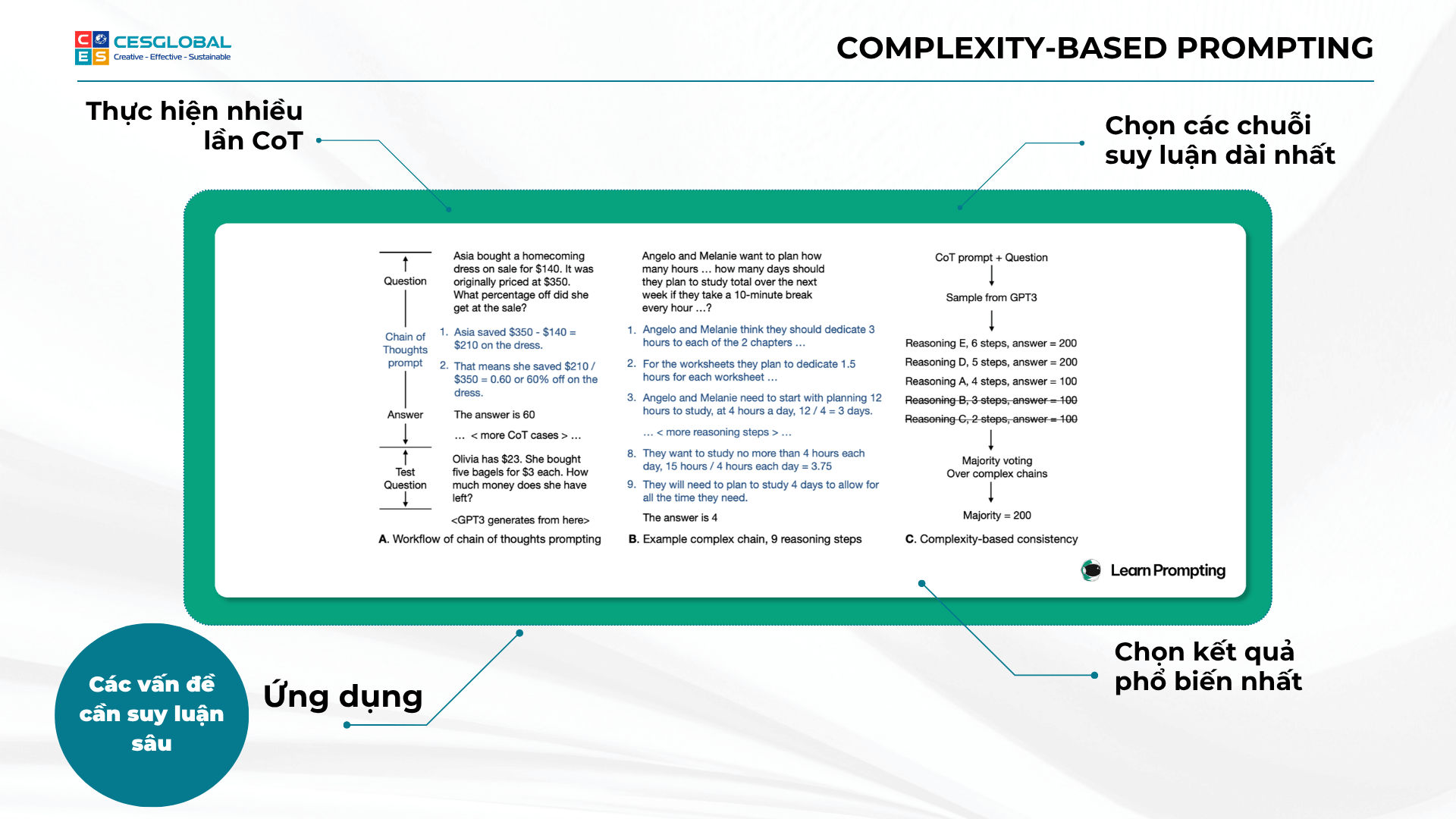

3.1. Self-Consistency (Tự Nhất Quán): Nâng Cao Độ Tin Cậy

Kỹ thuật này dựa trên ý tưởng rằng nếu AI đưa ra cùng một câu trả lời (hoặc các câu trả lời rất giống nhau) qua nhiều lần chạy với cùng một prompt (hoặc các biến thể nhỏ), thì câu trả lời đó có khả năng cao là đúng.

Cách thực hiện và Lợi ích của Self-Consistency

- Cách thực hiện: Chạy cùng prompt nhiều lần, chọn câu trả lời xuất hiện nhiều nhất.

- Lợi ích: Tăng độ tin cậy cho các nhiệm vụ suy luận phức tạp.

3.2. Retrieval Augmented Generation (RAG): Kết Hợp Sức Mạnh Của LLM và Dữ Liệu Ngoài

Khi LLM cần trả lời dựa trên thông tin rất mới, rất cụ thể hoặc dữ liệu nội bộ mà nó chưa được huấn luyện, RAG là giải pháp. Một system prompt tốt có thể hướng dẫn AI cách tích hợp thông tin này.

Cách hoạt động của RAG

Cách hoạt động (đơn giản hóa): Hệ thống RAG tìm kiếm trong cơ sở dữ liệu các văn bản liên quan và đưa vào prompt cùng câu hỏi gốc.

Ví dụ (Prompt được RAG tự động tạo): “Dựa trên thông tin sau: ‘[Văn bản A]’, ‘[Văn bản B]’, hãy trả lời: ‘[Câu hỏi người dùng]'”

Lợi ích và Lưu ý khi dùng RAG

- Lợi ích: Giảm “ảo giác”, truy cập thông tin cập nhật.

- Lưu ý: Xây dựng RAG đòi hỏi kiến thức kỹ thuật.

3.3. ReAct (Reason + Act): Cho Phép AI Tương Tác Với Công Cụ Bên Ngoài

Đây là một framework cho phép LLM không chỉ suy luận (Reason) mà còn thực hiện hành động (Act) bằng cách sử dụng các công cụ bên ngoài.

Cách hoạt động và Ví dụ ReAct

Cách hoạt động: LLM tạo chuỗi suy nghĩ và hành động, gọi công cụ, nhận kết quả, tiếp tục suy luận.

Ví dụ (mô phỏng): User: “Thủ đô Pháp là gì và dân số bao nhiêu?” -> LLM thực hiện các bước tìm kiếm và tổng hợp.

Lợi ích và Lưu ý khi dùng ReAct

- Lợi ích: Mở rộng khả năng LLM, giải quyết vấn đề thời gian thực.

- Lưu ý: Yêu cầu tích hợp API.

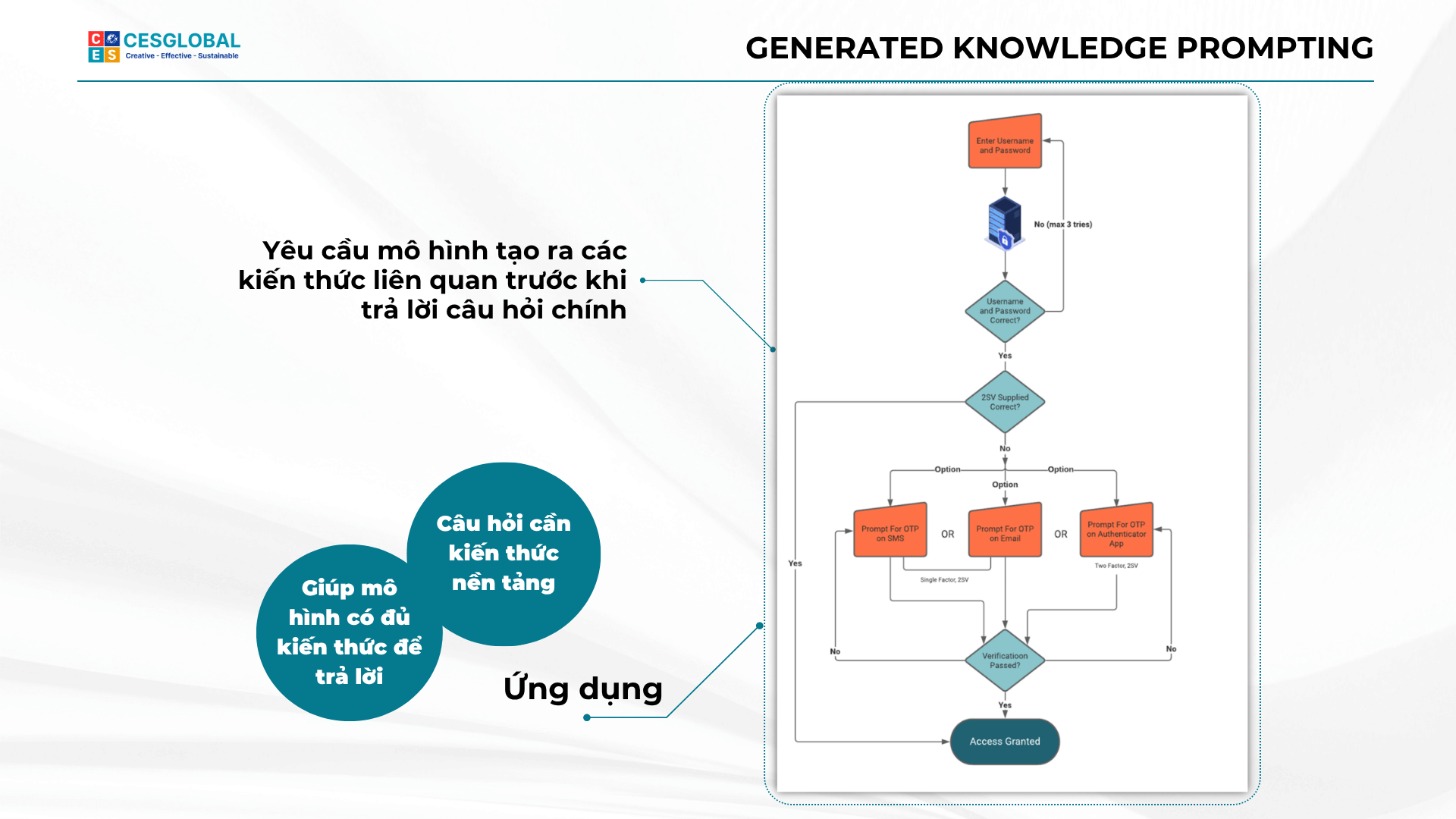

3.4. Automatic Prompt Engineer (APE): Để AI Tự Tối Ưu Prompt

Đây là một hướng nghiên cứu thú vị, nơi bạn sử dụng một LLM khác để tự động tạo ra hoặc tối ưu hóa các prompt cho một LLM mục tiêu.

Cách hoạt động của APE

Cách hoạt động (đơn giản hóa): LLM “kỹ sư prompt” tạo nhiều prompt ứng viên, đánh giá và chọn prompt tốt nhất.

Lợi ích và Lưu ý khi dùng APE

- Lợi ích: Khám phá cấu trúc prompt hiệu quả.

- Lưu ý: Đang phát triển, đòi hỏi tài nguyên tính toán.

Phần 4: Nguyên Tắc Vàng và Thực Hành Tốt Nhất Trong Prompt Engineering

Để tạo ra những prompt hiệu quả cho AI, việc tuân thủ các nguyên tắc và thực hành tốt nhất là vô cùng quan trọng.

Nguyên tắc cốt lõi

- Rõ ràng và Cụ thể là Vua: Luôn cố gắng làm cho prompt của bạn càng rõ ràng và cụ thể càng tốt. Tránh mơ hồ.

- Thử nghiệm và Lặp lại (Iterate): Không có prompt nào hoàn hảo ngay từ lần đầu. Hãy thử nghiệm, đánh giá kết quả, và tinh chỉnh prompt của bạn. Đây là một quá trình lặp đi lặp lại.

- Bắt đầu Đơn giản, Sau đó Mở rộng: Nếu bạn gặp khó khăn, hãy bắt đầu với một prompt đơn giản, đảm bảo nó hoạt động, rồi từ từ thêm các chi tiết và ràng buộc.

Hiểu biết về LLM và cách tiếp cận

- Hiểu Giới hạn của LLM: LLM rất mạnh mẽ nhưng không phải là toàn năng.

- Sử dụng Ngôn ngữ Tích cực: Hướng dẫn AI làm gì thay vì không làm gì.

- Chia nhỏ Nhiệm vụ Phức tạp: Nếu bạn có một nhiệm vụ lớn và phức tạp, hãy chia nó thành các bước nhỏ hơn.

- Cung cấp Ngữ cảnh Đầy đủ: Đừng cho rằng AI biết những gì bạn biết.

Đạo đức và An toàn

- Kiểm tra Xu hướng (Bias): LLM có thể chứa đựng các xu hướng ngầm.

- An toàn là trên hết: Tránh tạo ra các prompt có thể dẫn đến nội dung có hại.

Học hỏi liên tục

- Luôn Học hỏi và Cập nhật: Lĩnh vực LLM và Prompt Engineering phát triển rất nhanh. (Tham khảo OpenAI, GitHub).

Kết luận

Prompt Engineering là một kỹ năng thiết yếu để làm việc hiệu quả với AI. Bằng cách hiểu và áp dụng các nguyên tắc, kỹ thuật được trình bày, bạn có thể biến LLM thành những công cụ mạnh mẽ.

Hãy nhớ rằng, thực hành tạo nên sự hoàn hảo. Chúc bạn thành công!

>>>>>>> Xem thêm: Napkin AI – Ứng dụng tạo sơ đồ và trình bày nhanh chóng

🚀 Bạn muốn hiểu và ứng dụng AI hiệu quả hơn?

CES Global có khóa AI thực chiến giúp bạn làm chủ AI hàng đầu, ứng dụng thực tế.